生成AIに与えるプロンプト文は必ずしも文章である必要はない。というのも、WEBインターフェースで生成AIに与えたプロンプト文は、実際に生成AIに処理させる段階でトークン(token)≒単語に分解されるからである。

トークンについてのOPenAIによる公式の解説は、Open AI(2024) “What are tokens and how to count them?”にある。それによれば、1トークンが英語で約4文字、平均で75wordsが100トークンとされている。

自分が入れた文章のトークン数については、OpenAIが提供している下記WEBページ「Tokenizer」で調べることができる。

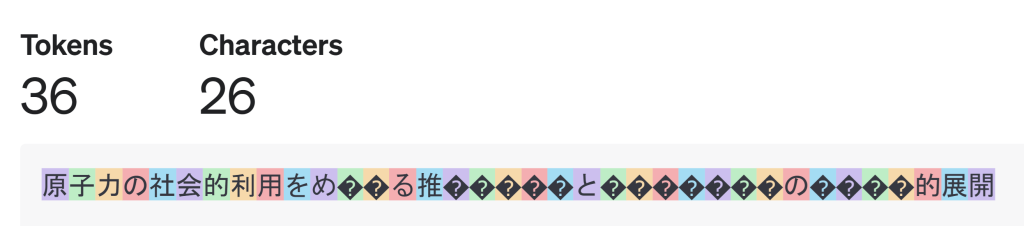

上記WEBページの「Tokenizer」で調べると、GPT-3.5およびGPT-4の場合、下記の図に示されているように、「原子力の社会的利用をめぐる推進論と批判論の歴史的展開」という26文字の日本語文で36トークンとなっている。

なお下図の色分けは、「原子力の社会的利用をめ」までの部分は、漢字・ひらがなともに、1文字1トークンとなっているが、「ぐ」の部分はひらがな1文字で2トークンとなっていることを示している。

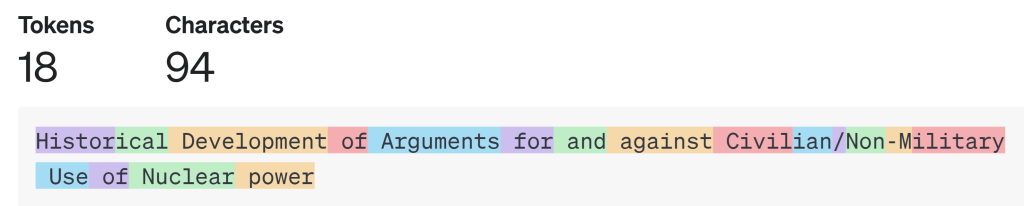

これに対して同語句の英訳であるHistorical Development of Arguments for and against Civilian/Non-Military Use of Nuclear powerという12words(94文字,Civilian/Non-Militaryも1word扱い)の英語文では、下記の図に示されているように、18トークンと、日本語の場合の約半分のトークン数となっている。

なお下図の色分けは、前置詞の「of」、「for」、「against」、接続詞の「and」だけでなく、「Development」、「Arguments」、「Nuclear」、「Power」といった単語が1wordで1トークンとなっていること、および、「Historical」や「Civilian」といった形容詞語句が1wordで2トークンとなっていることを示している。

「原子力の社会的利用をめぐる推進論と批判論の歴史的展開」という日本語の語句は、GPT-3で48トークンであったが、GPT-3.5およびGPT-4では36トークンとなり、トークン消費量が25%も減少し、3/4となっている。そしてさらにGPT-4oおよびGPT-4o miniでは、24トークンとGPT-3の半分にまで減少している。

(トークン消費量に関して、英語文の場合には日本語文とは異なり、それほどの劇的な性能向上はない。Historical Development of Arguments for and against Civilian/Non-Military Use of Nuclear powerという英文の場合、GPT-3で19トークン、GPT-3.5およびGPT-4で18トークン、GPT-4oおよびGPT-4o miniで17トークンというようにわずかな改善にとどまっている。)

日本語文に関するトークン分解に関するより詳しい具体的事例に基づく説明としては、OPenAI ”Inquiry Regarding Token Counting in Japanese for GPT-3 API” OPenAI>Documentation>API reference、2023年9月などが参考になる。

CRIMO voice(2024)「ChatGPTの文字数制限は1万字弱!無料・有料の違いや対処法を解説」2024/5/27によると、質問入力可能トークン数(日本語文字数)、および、最大回答トークン数(日本語文字数)の推定値は、下記の通りである。

| LLM | 質問入力可能トークン数 (日本語文字数) | 最大回答トークン数 (日本語文字数) |

| GPT-3.5 | 約16,000トークン (約10,000文字) | 約3,000トークン (約2,048文字) |

| GPT-4 | 約32,000トークン (約25,000文字) | 約20,000トークン (約15,625文字) |

上記のように、トークン消費量は日本語文よりも英文の方が少ないため、英語文で質問した方がより長い質問が可能となるとともに、より適切でより詳細な回答が一般的には生成される。

ピンバック: 生成AIによるレポート作成(その1)-課題に基づく内容構成の検討 | コスモピア AI研究室

ピンバック: 生成AIでの情報検索-移民問題(日本語プロンプト版3-Google Gemini編3) | コスモピア AI研究室

ピンバック: 生成AIによるレポート作成(その2)-課題に基づく内容構成の検討(Perplexity AI-Claude 3 Opus編)を選択 生成AIによるレポート作成(その2)-課題に基づく内容構成の検討(Perplexity AI-GPT4o編)