テキスト生成AI一覧

- OpenAI LP ChatGPT https://openai.com/blog/chatgpt

- Microsoft Copilot(旧Bing AI) https://copilot.microsoft.com/

- Perplexity AI https://www.perplexity.ai/

- Google Gemini https://gemini.google.com/

- Anthropic Claude AI https://claude.ai/chats

- Deep Seek R1 online

https://deepseek-r1.com/ - IBM watsonx試行版

- Meta AI Meta AI上記の1~7までは上記URLより無料利用が可能。8は2024/12/17現在のところ日本では利用できない。

なお多くのAIは、マルチモーダルなAI(汎用的テキスト生成AI)として、テキスト以外もアップロードして取り扱えたり、テキスト以外も生成できたりできるようになっているが、ここではテキスト生成以外の能力を持つものもテキスト生成AIとして挙げている。

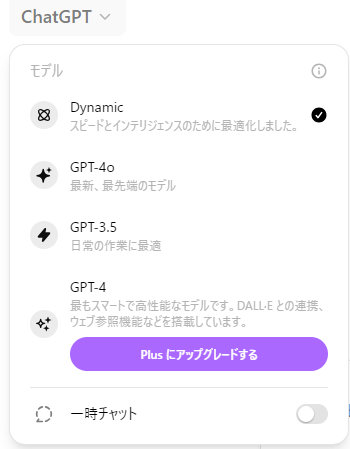

- OpenAI LP ChatGPT利用可能言語モデル:GPT-4o、GPT-4、GPT-3.5

無料ユーザーも、ユーザー登録をすれば、有料ユーザーと同じくGPT-4oも利用可能である。ただし一定時間内での繰り返し利用にはかなり強い制限がある。GPT-4oは、テキスト、画像、音声をシームレスに統合的に取り扱うことができ、生成した回答テキストに対するイラストの作成、生成した回答テキストの読み上げが標準で利用できる。(イラスト生成に使われる画像生成モデルは、OpenAIのDALL-E3である。)

- Microsoft Copilot(旧Bing AI)利用言語モデルはGPT-4で無料利用可能。

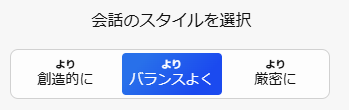

Open AIのChatGPTとは異なり、AIとの会話スタイル(conversation style)すなわち回答の精度(性格)に関して、下記のように「より創造的に(More Creative)」、「よりバランスの取れた(More Balanced)」、「より厳密に(More Precise)」という3つのモードが選択できるようになっている。より正確な情報を得たい場合には、「より厳密に(More Precise)」を選択した方が良い。(詳しくは、https://sl.bing.net/bR9YrsG5v3Iを参照されたい。)

なお、Microsoft Copilotは、無料ユーザー登録をし、同アカウントでログインした方がより長文のプロンプト文を受け付ける。 - Perplexity AI無料版の利用言語モデル:主としてGPT-3, 補助的にGPT-4

有料版の利用言語モデル:下図のように、GPT-4o、GPT-4 Turbo、Claude3 Opus、Sonar Large 32Kなどの中から一つを選択できる。

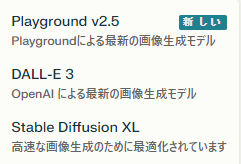

なおPerplexity AI有料版は、OpenAI ChatGPTのGPT-4oのようにテキスト、画像、音声をシームレスに統合的に取り扱うことはできないが、画像生成モデルに関してPlayground v2.5、DALL-E 3、Stable Diffusion XLの3つを利用可能である。また生成する画像のスタイルに関して、下記のように「絵画」、「写真」、「イラスト」、「図表」の4つをワンクリックで利用できるようになっている。 - Google Gemini利用言語モデル:無料版はGemini 1、有料版はGemini 1.5 Pro

- Anthropic Claude AI利用言語モデル:無料版はClaude3 Sonnet、

有料版のClaud ProはClaude 3 Opus文書ファイル(1ファイルあたり10MB以下、同時に最大5ファイル)および画像ファイルをアップロード可能

- IBMの生成AI「watsox」試行版本WEBページよりユーザー登録することで、IBMの生成AI利用サービス「watsox」を30日間無料で利用できる。その際にはGoogleアカウントとの連携により簡単に利用ができるようになっている。(もちろんIBMアカウントの新規ユーザー登録をしても良い。)

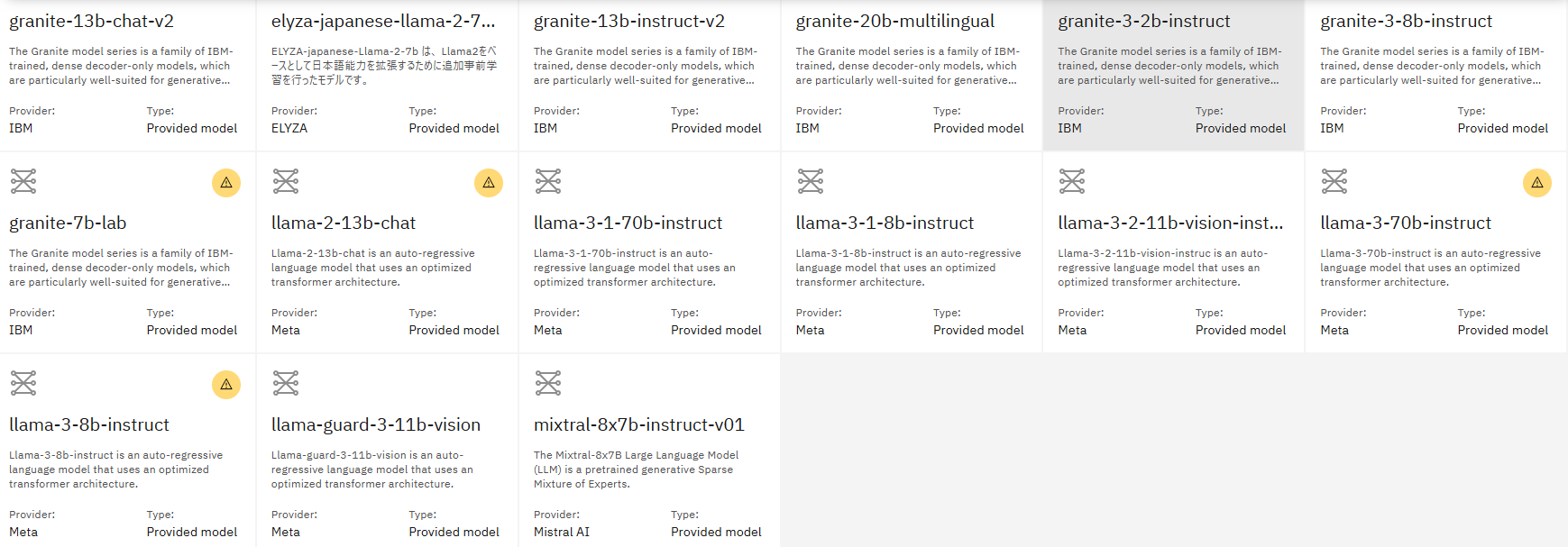

LLMとしては、下記の図にあるように、IBMが独自開発した「granite」シリーズ以外に、Metaが開発した「llama」シリーズなどが利用できるようになっている。(2024年12月16日現在)

- Meta AI

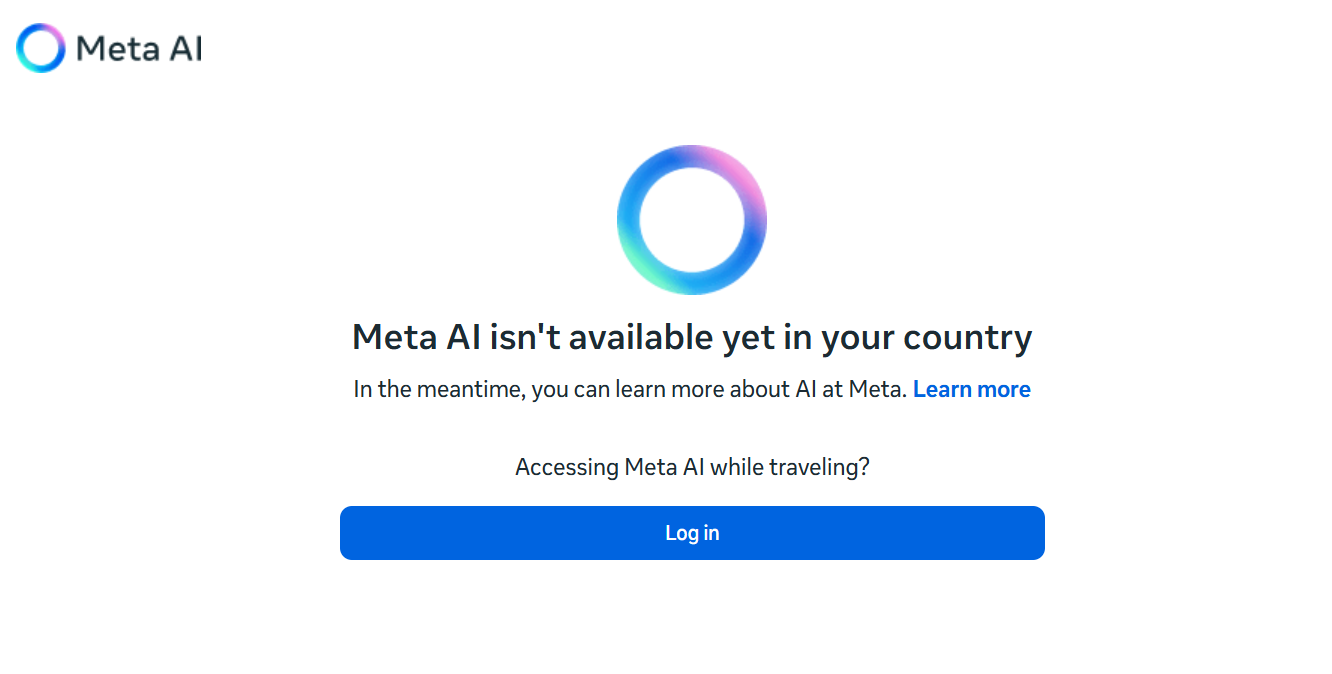

https://www.meta.ai/Meta(Facebook)のMeta AIは、アメリカ等では同社のInstagram、Messenger、WhatsAppなどで使えるが、日本では下記のように2024年12月17日現在ではまだ利用できない。

西田宗千佳(2024)「Meta AI「世界一使われるAIアシスタント」へ Facebookで「理想の自分」生成」2024年9月26日によれば、Metaは2024年9月25日に同社が開催した年次開発者会議「Meta Connect 2024」における基調講演において、同社のMetaAIについて「世界で最も使われるマルチモーダルなAIアシスタント」として強化していくことを発表したが、前述のように日本ではまだ利用できない。

なおMeta AIの概要については、Meta “Setting a new standard for immersive AI content”のWEBページからその詳細がわかるようになっている。

動画用サービスのMeta Movie Genに関しては、「テキストによる動画生成」(text to video:Generate videos from text)、「テキストによる動画編集」(Edit video with text, Instruction-Gioded Precise Video Editing)、「アップロードした写真に基づく動画生成」(Produce personalized videos, Video Personalization and Consitency)、「テキストによるサウンド生成」(Create sound effects and soundtracks, Video-to-Audio)などが紹介されている。

[参考資料]Meta(2024) Movie Gen: A Cast of Media Foundation Modeles, 92pp

https://ai.meta.com/static-resource/movie-gen-research-paper - サイバーエージェント